Apple pod palbou. Důvodem je kontroverzní detekce dětské nahoty

- Apple se stal opět terčem kritiky

- Zastavil vývoj důležitého nástroje

- Americký brand se chce vydat jinudy

Společnost Apple odhalila další podrobnosti o svém rozhodnutí upustit od vývoje nástroje pro skenování fotografií na iCloudu zaměřeného na ochranu soukromí. Cílem tohoto projektu mělo být odhalit fotografie, které se týkají sexuálního zneužívání dětí (CSAM). Heat Initiative (skupina pro ochranu dětí) obnovila tlak na to, aby Apple dělal v této věci více. Proto nyní americký gigant přichází s vysvětlením.

Apple projekt zrušil

Technologický gigant z Cupertina poprvé oznámil nástroj pro skenování CSAM v srpnu 2021. O měsíc později ji pozastavil kvůli obavám v oblasti ochrany soukromí a digitálního práva. Kritici varovali, že nástroj by mohl být zneužit k ohrožení soukromí uživatelů služby iCloud v širším měřítku.

Ředitel společnosti Apple pro ochranu soukromí uživatelů a bezpečnost dětí Erik Neuenschwander nyní rozhodnutí společnosti upřesnil pro server Wired. Uvedl, že takové materiály jsou odporné a Apple rozhodně udělá vše možné, aby jejich šíření zastavil.

Je jednání ale dostatečně odpovědné?

Dále vysvětlil, že po rozsáhlých konzultacích se společnost Apple rozhodla, že nemůže pokračovat. Hlavním důvodem má být velká zranitelnost v oblasti úniku dat a možnosti následného sledování citlivých údajů všech uživatelů na iCloudu.

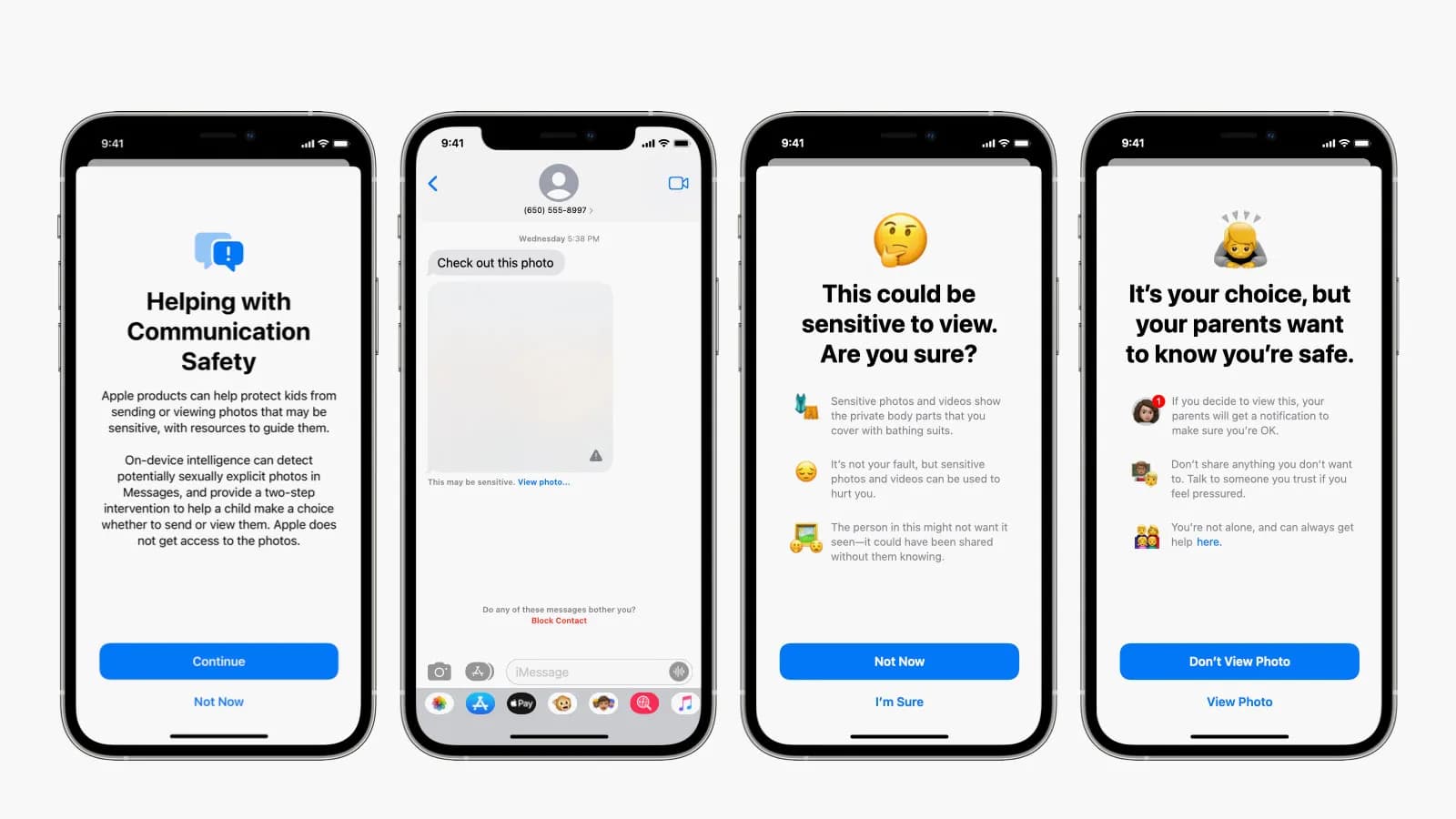

Místo tohoto zastaveného projektu zaměřeného na iCloud Apple přesunul svoji pozornost na balíček funkcí pod názvem „Communication Safety features“. Ty mají umožňovat bezpečnější interakci uživatelů v aplikacích Messages, FaceTime a AirDrop.

Celá situace se nelíbí Heat Initiative, která vyjádřila zklamání nad tím, že Apple nedokáže technologicky vyřešit tento problém. Jedná se o velmi složitý problém, který v současné době bohužel asi nemá správné řešení.

Autor článku

Bývalý redaktor webu Inteligentnisvet.cz.